Comprendre la conteneurisation : de quoi parle-t-on ?

Un conteneur d’application, c’est quoi ?

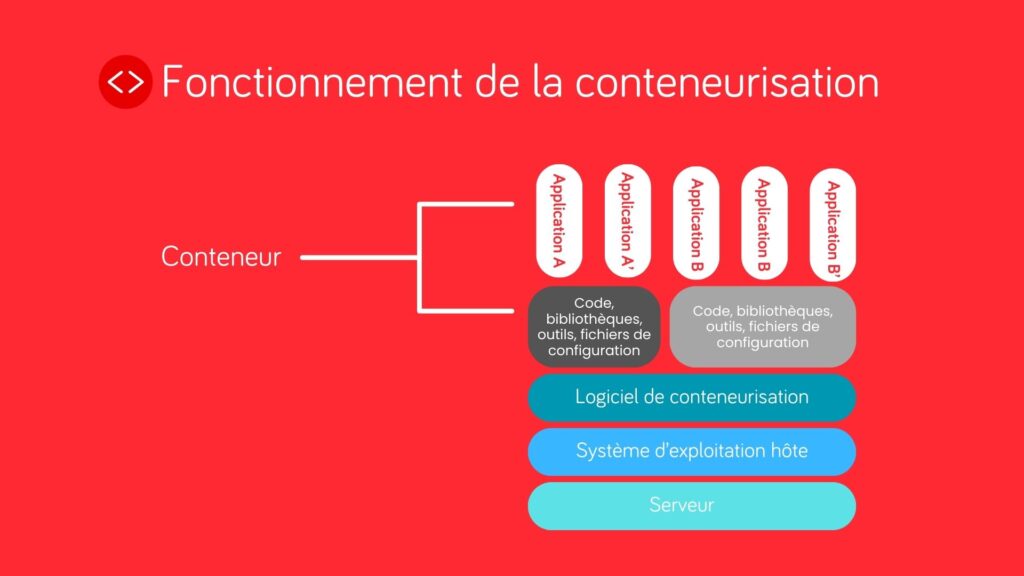

Conteneuriser une application consiste à encapsuler l’application et ses dépendances en les regroupant dans une unité d’exécution isolée appelée « conteneur ».

Un conteneur est, en quelque sorte, une boîte autonome dans laquelle on place une application avec tout ce dont elle a besoin pour fonctionner : le code, les bibliothèques, les outils, les fichiers de configuration. Cela permet d’isoler l’application dans un conteneur spécifiquement conçu et dimensionné pour elle et ses composants.

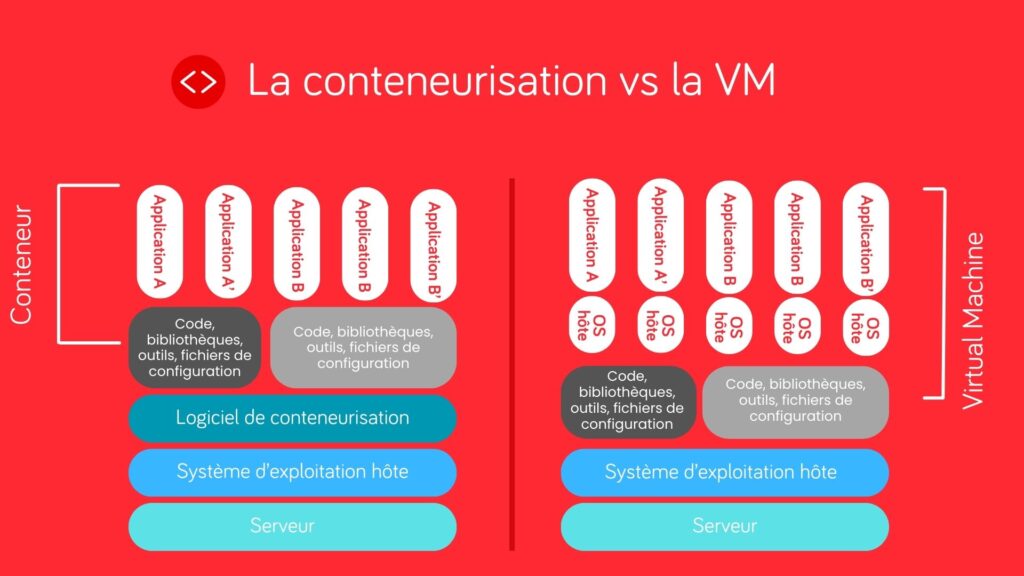

Contrairement à une machine virtuelle (VM) qui embarque un système d’exploitation complet, un conteneur partage le noyau du système d’exploitation de l’hôte. Cette architecture lui confère des avantages techniques majeurs, comme l’utilisation de moins de ressources consommées par rapport à une machine virtuelle. Le démarrage devient aussi plus rapide, puisqu’on peut, grâce à une mise en conteneur, lancer des instances en quelques secondes. De plus, la gestion devient plus simplifiée grâce à un déploiement et une mise à l’échelle réalisée avec une plus grande agilité.

La conteneurisation est une approche qui repose sur des mécanismes de virtualisation. Mais elle est différente de la virtualisation traditionnelle faite par machine virtuelle. Chacune de ces technologies a ses propres avantages, et le choix entre les deux dépend étroitement du contexte technique et des objectifs du projet.

Virtualisation ou conteneurisation : comment choisir ?

La conteneurisation et la virtualisation répondent à des logiques similaires – isoler les environnements d’exécution – mais par des approches techniques distinctes.

La virtualisation repose sur la création de machines virtuelles indépendantes, chacune dotée de son propre système d’exploitation. Cela offre une isolation forte, idéale pour certains cas d’usage comme l’hébergement d’environnements multi-systèmes ou la cohabitation de technologies incompatibles. En revanche, elle est dite “gourmande” en ressources.

À l’inverse, la conteneurisation repose sur une isolation au niveau de l’application, plus légère, plus rapide à déployer et plus adaptée aux architectures en micro-services ou à la modernisation d’applications existantes.

Il n’y a pas de réponse univoque à la question “quelle approche est à privilégier ?”. Tout dépend des contraintes techniques, des priorités de l’entreprise, et du niveau de flexibilité recherché.

C’est pourquoi nous analysons avec nos clients leurs objectifs opérationnels et techniques pour leur proposer la solution la plus adéquate : virtualisation, conteneurisation ou combinaison des deux. Et pour bénéficier de nos conseils, tout commence par un premier rendez-vous.

Une application plus facilement fonctionnelle grâce à la conteneurisation

L’un des avantages majeurs d’un conteneur, c’est qu’il garantit le même comportement de l’application partout : sur le poste d’un développeur, sur un serveur de test, ou dans un environnement cloud.

Cela permet :

- De réduire les erreurs liées aux différences d’environnement,

- De standardiser les déploiements,

- De répliquer facilement l’application sur différents serveurs ou infrastructures.

Exemples de cas d’usage de conteneurisation

Isoler en microservices et en briques

Une application est souvent divisée en plusieurs parties indépendantes (les microservices). Chaque brique (comme la gestion des utilisateurs ou la génération de factures) tourne dans son propre conteneur.

La conteneurisation permet un contrôle précis des ressources allouées à chaque composant. On peut définir exactement combien de mémoire, de CPU ou de stockage un conteneur peut utiliser, ce qui évite qu’un service monopolise l’ensemble des ressources de la machine. Cela garantit une meilleure stabilité et une répartition efficace des charges, tout en laissant la possibilité de mutualiser des conteneurs sur une même infrastructure pour optimiser les coûts et l’usage des serveurs.

Pour résumer, cela permet d’isoler les composants pour mieux les maintenir, de mettre à jour indépendamment chaque partie et de mieux répartir les charges et les ressources.

Cloud et infrastructures hybrides

Les plateformes cloud comme AWS, Azure ou Google Cloud intègrent nativement les conteneurs. Cela favorise une intégration rapide dans des solutions cloud existantes, une portabilité entre cloud et infrastructures internes et une gestion simplifiée des mises à l’échelle.

Par exemple, la conteneurisation dans le cloud facilite la montée en charge des applications, puisque, grâce aux conteneurs, il est possible de répartir une application sur plusieurs instances de manière rapide et efficace. Cette approche rend l’élasticité bien plus accessible : on peut ajuster dynamiquement les ressources (comme la mémoire ou la puissance CPU) en fonction de la charge, quasiment à la volée. Contrairement à un serveur physique, limité par sa capacité matérielle et difficile à faire évoluer s’il est déjà sous-dimensionné, le cloud permet de scaler horizontalement (en multipliant les conteneurs) ou verticalement (en augmentant les ressources) avec beaucoup plus de souplesse. C’est cette flexibilité qui rend la conteneurisation particulièrement adaptée aux environnements cloud modernes.

Développement local identique aux environnements de recette ou de production

Avec la conteneurisation, le développeur travaille dans les mêmes conditions que les autres parties prenantes du projet (testeurs, utilisateurs métier…). Cette homogénéité garantit une parfaite cohérence entre les phases de développement, de test et de production, et élimine les écarts de comportement souvent résumés par la fameuse phrase : « ça fonctionnait sur ma machine ».

Un simple fichier de configuration (docker-compose.yml) permet de lancer un environnement complet, avec base de données, API et interface, identique à celui de production.

Chez AxioCode, nous utilisons par exemple l’outil Docker aussi bien pour les développements locaux que pour les déploiements en test ou en production. Selon Stack Overflow Developer Survey, l’année passée, Docker était l’outil le plus utilisé par les développeurs. Il s’intègre facilement dans les environnements de développement (comme Visual Studio Code) et les plateformes DevOps (comme GitLab), tout en étant compatible avec les principaux fournisseurs de cloud.

Pourquoi conteneuriser vos applications ?

Gagner en efficacité sur les développements

En conteneurisant une application, les développeurs n’ont plus besoin d’installer manuellement des dépendances ou de configurer leur environnement (“machine”) pour faire tourner le projet. Tout est déjà défini dans le conteneur.

Cela permet de :

- Lancer rapidement un projet sans étape fastidieuse,

- Travailler en équipe dans un environnement unifié,

- Automatiser les tests et les déploiements de manière fluide.

Faciliter le déploiement et la montée en charge

Les conteneurs sont rapides à déployer et faciles à répliquer. Cela signifie que :

- On peut lancer plusieurs instances d’une même application si la charge augmente,

- Le déploiement d’une nouvelle version se fait en quelques secondes,

- L’application peut tourner sur différents environnements (sur site, dans le cloud, en hybride).

Isoler une application héritée (legacy)

Conteneuriser ne signifie pas réécrire une application. C’est une solution efficace pour faire évoluer progressivement une application ancienne :

- On encapsule l’application dans un conteneur, même si elle repose sur une stack vieillissante,

- On améliore sa portabilité sans changer son code,

- On réduit les risques liés à des environnements complexes ou obsolètes.

Dans un environnement legacy, la conteneurisation réduit les risques liés à la dépendance aux outils, versions et/ou technologies obsolètes. Un conteneur est créé à partir d’une image (par exemple, une version précise de PHP) ; si cette image disparaît ou devient inaccessible, il devient impossible de recréer l’environnement. Pour éviter cela, des outils comme Docker permettent de stocker les images localement ou dans un registre privé, assurant la pérennité des environnements critiques. Ce mécanisme garantit que les anciennes versions restent disponibles, même si elles ne sont plus maintenues publiquement.

C’est une approche utilisée chez AxioCode dans les projets de modernisation progressive. En effet, la conteneurisation permet d’éviter les risques liés à l’obsolescence lorsqu’il est nécessaire d’isoler une application héritée (legacy) pour pouvoir continuer à l’utiliser en sécurité, le temps du développement d’une nouvelle solution qui viendra remplacer progressivement l’ancienne application.

De fait, la conteneurisation simplifie également le développement applicatif. En encapsulant tous les outils nécessaires dans des conteneurs (PHP, Node, bases de données, etc.), chaque projet dispose de son environnement dédié, isolé du système hôte et des autres projets. Cela permet, par exemple, de développer simultanément une application Symfony 7 et une autre en Symfony 6 sans conflit de dépendances ou de versions. Chaque conteneur embarque exactement ce dont il a besoin, ce qui garantit une reproductibilité parfaite et évite les effets de bord liés à l’environnement de la machine du développeur. Les projets sont donc mieux isolés, plus faciles à maintenir et plus cohérents pour les équipes.

Renforcer la sécurité et le contrôle

Les conteneurs offrent un niveau d’isolement qui permet de mieux maîtriser ce qu’une application peut faire ou non :

- Elle ne voit que ce qui lui est autorisé (réseau, fichiers, ressources),

- On peut scanner les conteneurs à la recherche de vulnérabilités,

- Chaque version est maîtrisée et traçable, ce qui facilite les audits et les correctifs.

La conteneurisation facilite les tests en assurant un environnement stable et reproductible. Chaque test s’exécute dans un conteneur isolé, identique à celui utilisé en production, ce qui réduit les erreurs liées aux différences de configuration. Elle permet aussi de lancer rapidement des bases de données ou des services simulés (mocks) pour les tests d’intégration, rendant les pipelines CI/CD plus fiables et automatisables.

Conclusion

La conteneurisation est devenue une pratique courante et stratégique dans le développement logiciel moderne. Elle permet d’accélérer les développements, de sécuriser les déploiements, et de faciliter la maintenance des applications, qu’elles soient nouvelles ou déjà existantes.

Chez AxioCode, nous l’utilisons pour concevoir des applications robustes, évolutives et adaptées aux exigences actuelles des entreprises. Dans le cadre d’une refonte ou d’un projet sur-mesure, la conteneurisation fait partie de nos pratiques pour garantir fiabilité, performance et maîtrise technique.